Большинство пользователей Android задаются вопросом, как отключить Google Assistant.

Знакомая история: у вас есть хороший Android-телефон, который работает как мечта, но вы продолжаете случайно запускать встроенный голосовой помощник. Возможно, Google Assistant появляется, когда вы говорите определенную фразу в разговоре, или отвечает на то, что кто-то говорит в телешоу или в рекламе.

Хотя эта функция, несомненно, может быть полезной, ее предложение помочь в неудобное время может оказаться очень раздражающим. Но не бойтесь: есть простой способ отключить Google Assistant.

Вот пошаговые инструкции по отключению Google Assistant на телефоне или планшете Android, а также на умном динамике Google Home или Nest, чтобы эта функция вас не беспокоила. Также вы узнаете как отключить гугл ассистент в наушниках.

Как полностью отключить Google Assistant на Android

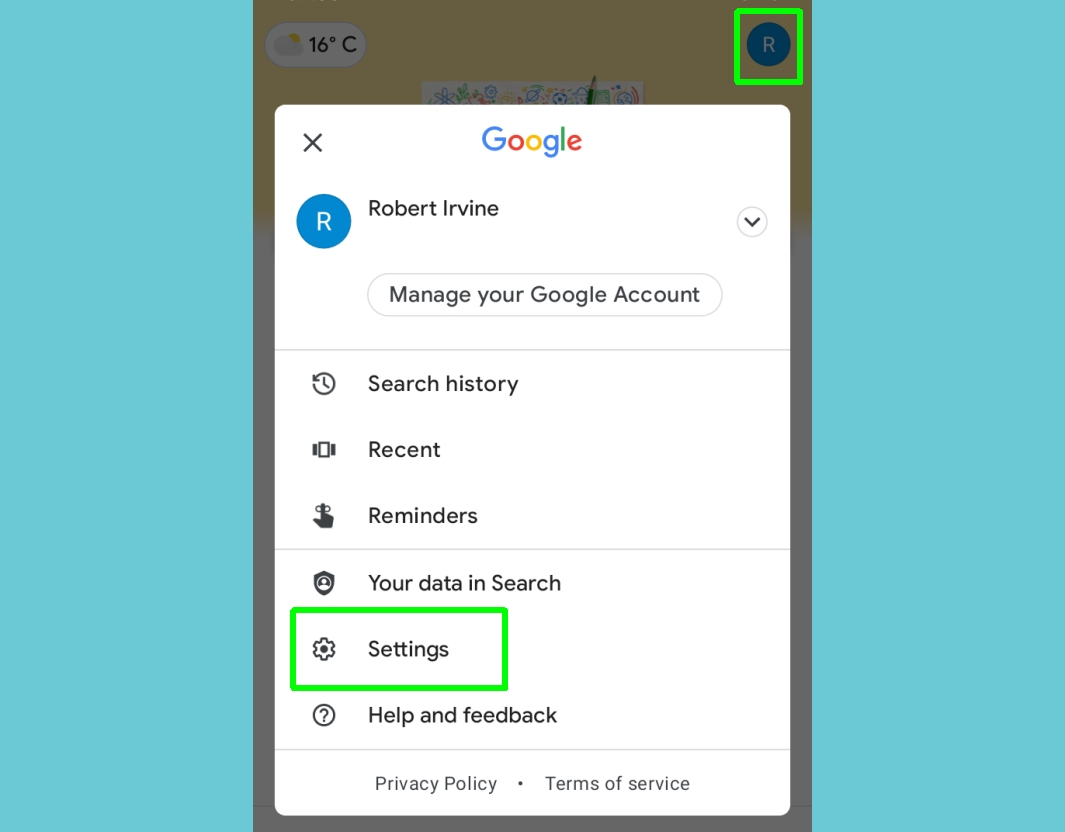

1. Чтобы отключить ассистент, откройте приложение Google на телефоне (или планшете) с Android. Коснитесь значка своего профиля в правом верхнем углу и выберите Настройки.

Если вы не видите эту опцию, нажмите кнопку “Еще” с тремя точками в углу экрана и выберите Настройки там.

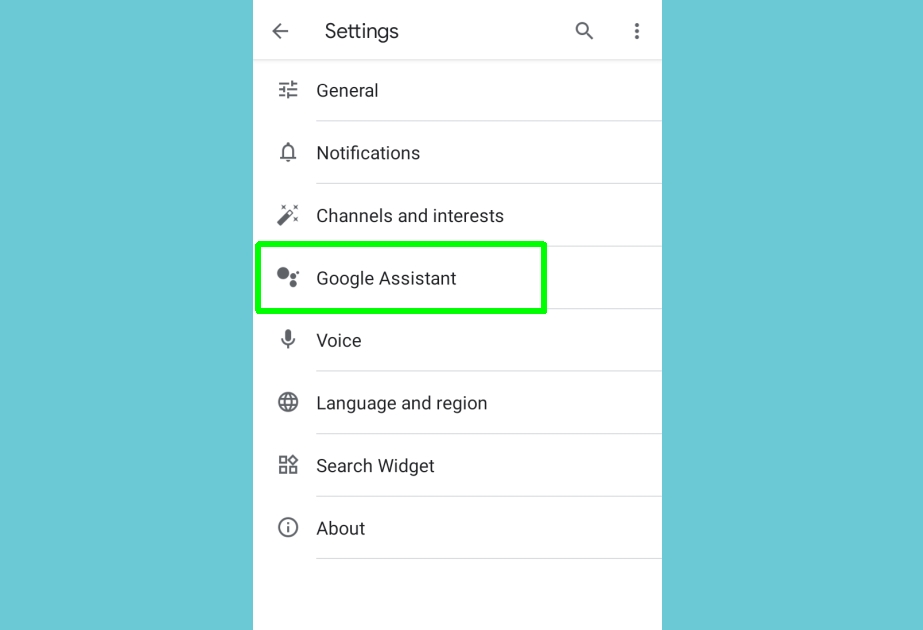

2. Когда откроется экран настроек, коснитесь опции “Google Ассистент”. Вы найдете её примерно в середине списка.

3. На некоторых телефонах Android теперь можно отключить Google Assistant просто выключив переключатель рядом с этой опцией. Таким способом можно отключить google ассистент на Xiaomi и на Samsung.

4. Если вы не видите эту опцию, проведите вниз до “Устройства с Ассистентом” (или устройства на некоторых телефонах), коснитесь телефона и выключите Google Assistant с помощью переключателя.

В прошивку некоторых телефонов Android, например последних моделей Motorola, встроен Google Assistant, что означает, что его нельзя отключить с помощью вышеуказанных методов

Если вы не видите переключатель, упомянутый в шагах 3 и 4, проведите вниз до раздела “Все настройки” на экране настроек Google Ассистента. Нажмите Общие, а также выключите Google Assistant там.

Нажмите «Выключить» чтобы подтвердить, что вы хотите полностью отключить эту функцию.

Как отключить Google Assistant на динамиках Google Home

Вы не можете отключить Google Assistant на динамике Google Home или Nest, но вы можете отключить микрофон, чтобы Google вас не слушал. Нажмите кнопку микрофона на динамике, чтобы включить или выключить его.

Вы найдете эту кнопку на задней панели динамиков Google Home и Google Nest, а также рядом со шнуром питания на Google Home Mini / Google Nest Mini.

Как отключить Google Assistant в наушниках – Включение или отключение голосовых уведомлений