Игры FromSoftware используют ту же основу для создания персонажей, что и Demon’s Souls. Каждая запись вносит небольшие изменения в то, как она работает, и одним из самых больших изменений стало добавление деформации лица в Bloodborne. Это было недоступно для игрока: это было сделано для того, чтобы можно было создавать персонажей NPC, на лицах которых были видны следы многократного переливания крови.

Если вы не играли в Bloodborne, никаких спойлеров, но оказывается, что чудо-кровь Ярнама, возможно, это еще не все.

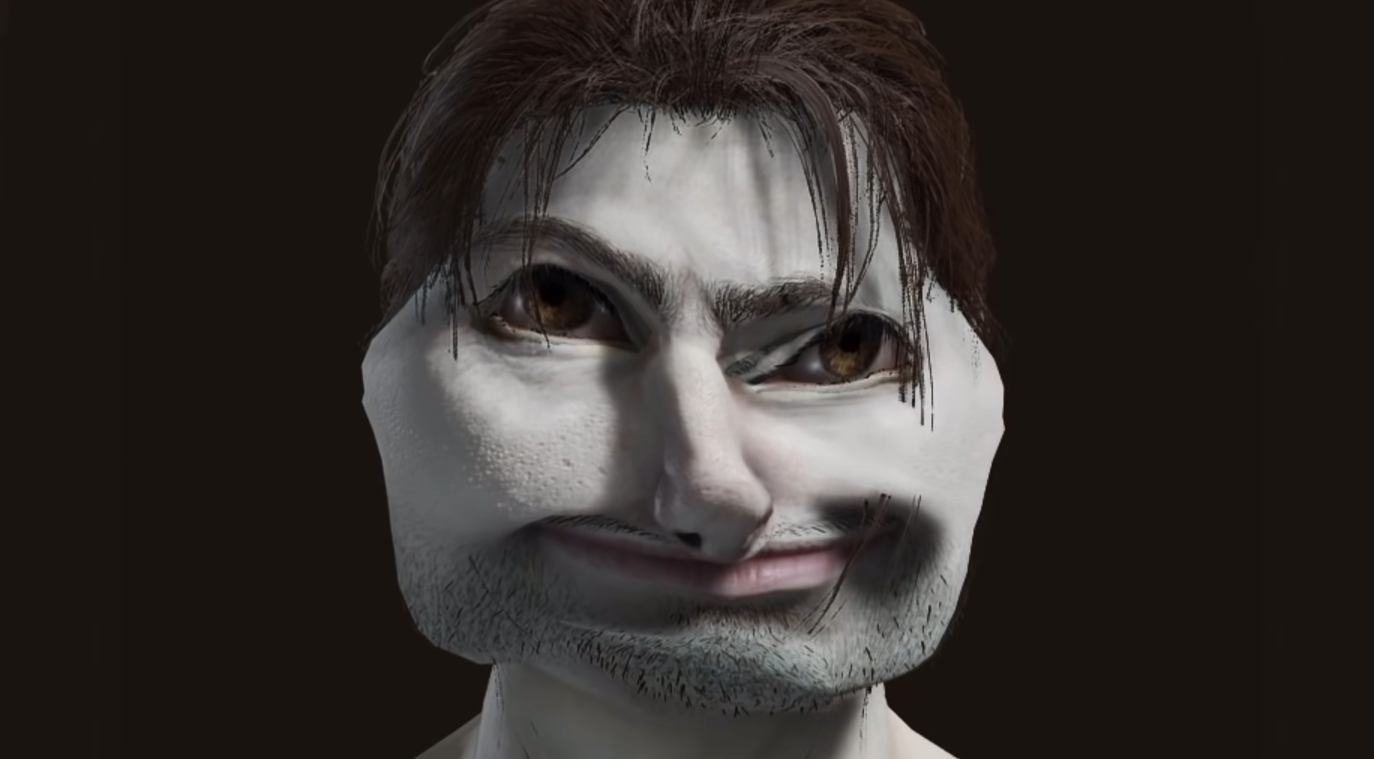

Эта функция осталась в Dark Souls 3 (которая была выпущена после Bloodborne) и теперь была обнаружена в Elden Ring давним экспертом по Souls и сборщиком данных ZullieTheWitch. Как вы можете видеть ниже, эта штука позволяет вам создать Шрека за считанные секунды.

Если вы не Зулли, вы не можете получить к нему доступ в Elden Ring — пока. Однако тот факт, что он уже там, означает, что он, вероятно, будет разблокирован с помощью модов достаточно скоро, тогда мы все сможем бегать вокруг Маргит.

Справедливо отметить, что система создания персонажей Elden Ring на сегодняшний день является наиболее полнофункциональной и может создавать самые разные образы. Действительно, одна из вещей, которыми я восхищаюсь в подходе студии к созданию персонажей, заключается в том, что довольно сложно, не впадая в крайности, создать персонажа, который не чувствует себя вписывающимся в этот мир.

Тем не менее, открытие Зулли действительно показывает, что создание персонажей здесь, несмотря на улучшения, все еще остается той же (совершенно хорошей) системой. И эй, все, что отдаленно напоминает какой-либо аспект Bloodborne на ПК, всегда будет вызывать у меня бурную реакцию.