Как обновить Windows 11 Home до Pro Edition

Windows 11 теперь официально доступна, и, как и предыдущие версии Windows, она будет выпущена в нескольких различных редакциях. Выпуски Windows 11 аналогичны выпускам Windows 10, и разные выпуски содержат определенные функции, которые делают операционную систему более адаптированной для разных пользователей. Для широкой публики вы найдете две основные версии — Windows 11 Home и Windows 11 Pro. Как следует из названия, Windows 11 Pro — это более многофункциональная версия, но большинство ноутбуков поставляются с версией Home. Даже собственные устройства Microsoft Surface поставляются с Windows 10 Home, если вы не покупаете их бизнес-варианты, которые поставляются с Windows 11 Pro. В этом руководстве мы покажем вам, как выполнить обновление с Windows 11 Домашняя до Pro и почему вы можете захотеть этого.

Если вы хотите узнать больше о различных выпусках, вы можете прочитать нашу статью о SKU Windows 11. Помимо Home и Pro, существует множество выпусков для деловых и образовательных пользователей. Существуют также специальные версии для различных типов устройств.

Зачем вам Windows 11 Pro?

Как мы уже упоминали, Windows 11 Pro содержит определенные функции, которых нет в домашней версии, но чего именно вам не хватает? Что ж, для большинства пользователей вас, вероятно, вполне устраивает Windows 11 Home. Как следует из названия, функции в Pro edition больше ориентированы на профессионалов и корпоративные ПК. Тем не менее, есть веские причины хотеть этого. Вот краткий обзор различий между этими двумя.

| Особенность | Windows 11 Домашняя | Windows 11 Pro |

|---|---|---|

| Настройка с локальной учетной записью | Нет | Нет |

| Присоединяйтесь к Active Directory/Azure AD | Нет | Да |

| Гипер-V | Нет | Да |

| Песочница Windows | Нет | Да |

| Удаленный рабочий стол Майкрософт | Только клиент | Да |

| Шифрование устройства BitLocker | Нет | Да |

| Защита информации Windows | Нет | Да |

| Управление мобильными устройствами (MDM) | Нет | Да |

| Групповая политика | Нет | Да |

| Роуминг состояния предприятия с Azure | Нет | Да |

| Назначенный доступ | Нет | Да |

| Динамическое обеспечение | Нет | Да |

| Центр обновления Windows для бизнеса | Нет | Да |

| Режим киоска | Нет | Да |

| Максимальная оперативная память | 128 ГБ | 2 ТБ |

| Максимальное количество процессоров | 1 | 2 |

| Максимальное количество ядер процессора | 64 | 128 |

Один из Pro-эксклюзивной функцией является шифрование BitLocker, которое помогает защитить данные на вашем ПК от внешних злоумышленников. Шифрование ваших данных означает, что только вы можете получить к ним доступ, и это важно, если вы беспокоитесь о конфиденциальности и безопасности данных.

Еще одна эксклюзивная функция — поддержка удаленного рабочего стола. Это позволяет вам удаленно подключаться к вашему ПК и управлять им из любого места, что может быть очень полезно, например, для компьютеров, которые вы оставляете в офисе. Также есть поддержка виртуализации Hyper-V. Это позволяет вам создавать и запускать виртуальные машины, чтобы вы могли тестировать определенные среды или опасное программное обеспечение, не повреждая главный компьютер.

Однако стоит отметить, что есть несколько приложений, предлагающих аналогичные инструменты, если у вас Windows 11 Home. VMware Workstation Player — пример приложения для запуска виртуальных машин, а TeamViewer хорош для доступа к удаленным ПК. Вам не нужно Pro издание обязательно.

Больше нишевых функций для Pro включают возможность присоединиться к Azure Active Directory или бизнес-домену. Изначально Виндовс 11 Pro также позволил вам настроить ваше устройство с помощью локальной учетной записи из коробки, но теперь для обеих версий требуется подключение к Интернету, и вам все еще нужна учетная запись Microsoft для настройки Windows 11 Pro для личного пользования. Однако в обеих версиях есть обходной путь.

Как обновить Windows 11 Домашняя на Pro

Если вы настроены на обновление с Windows 11 Домашняя до Pro, вот что вам нужно сделать:

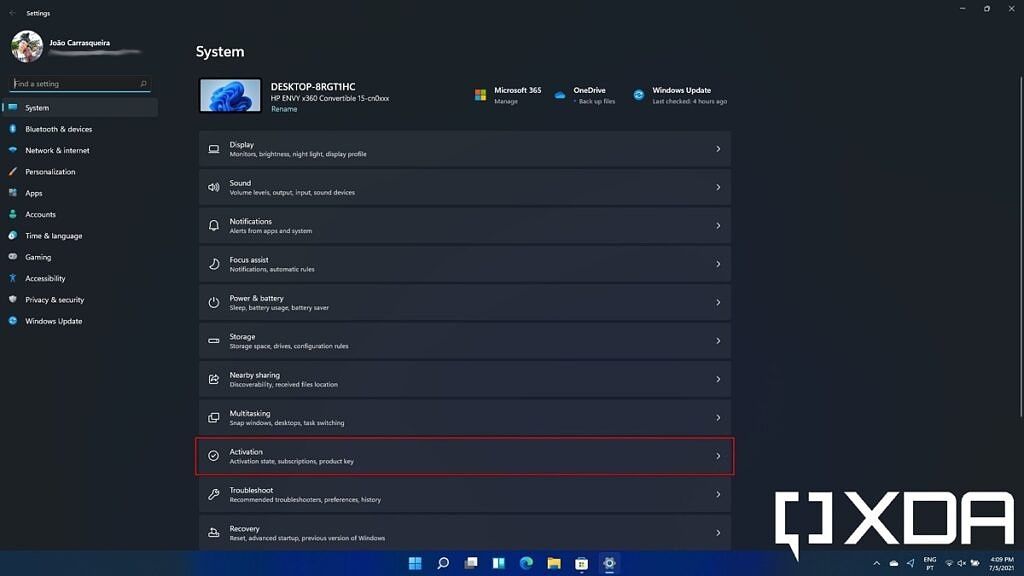

- Откройте приложение «Настройки» и выберите Активация.

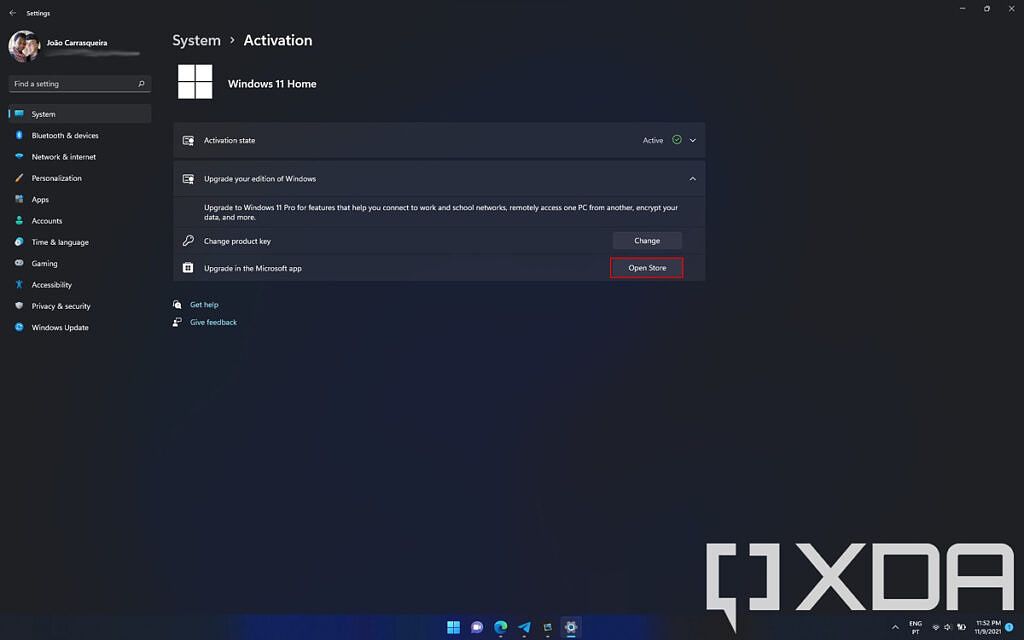

- Развернуть раздел Обновите свою версию Windows, чтобы увидеть ваши варианты. Если вы хотите купить обновление до Windows 11 Pro нажмите Открыть магазин.

- Вы увидите сравнение функций между Home и Pro редакций Windows с возможностью покупки обновления. Поскольку лицензии Windows 10 и Windows 11 одинаковые, в Магазине Microsoft отображаются обе операционные системы, но работать все будет одинаково.

- Нажмите Купить получить новую лицензию. Если у вас Windows 11 Home, обновление должно стоить 99 долларов.

- Вам нужно будет ввести свой пароль и заполнить платежные данные, если вы еще этого не сделали.

- После того, как вы купите и примените обновление, ваш компьютер необходимо будет перезагрузить, чтобы активировать новые функции.

Использование существующего ключа продукта

Если у вас уже есть ключ продукта для Windows 11 Proвы можете активировать его, выполнив следующие действия:

- Перейдите к Активация в приложении «Параметры Windows 11», затем нажмите Изменять следующий на Изменить ключ продукта.

- Вам будет предложено предоставить разрешение администратора для запуска инструмента активации Windows, после чего вы сможете ввести в свою учетную запись ключ продукта Windows 11 Pro.

- После проверки ключа вам необходимо перезагрузить компьютер, чтобы активировать возможности Pro.

Windows 11 Домашняя и Pro на самом деле основаны на одних и тех же установочных файлах, поэтому вам не нужно переустанавливать Windows или что-то еще для обновления. Простой перезапуск настроит вашу версию Windows, и вы сможете приступить к работе в следующий раз, когда будете использовать свой компьютер.